Avec le buzz suscité par les intelligences artificielles génératives – c’est-à-dire des IA qui ont la faculté de créer (texte, image, son) – depuis le lancement de ChatGPT1 et des outils de création d’images comme DALL-E et Midjourney, nul n’échappe à ce tsunami qui est de nature à disrupter un pan d’activités humaines aussi bien pour les cols bleus que pour les cols blancs, épargnés jusqu’alors par l’automatisation et la robotique. L’enjeu est de savoir si, au regard des entraînements et renforcements réalisés, des jeux de données utilisées et des éventuels biais, les algorithmes sont éthiques et s’ils sont inclusifs ou non. Il importe également de questionner le rôle de l’humain. Les données massives (big data), caractérisées en premier lieu par le volume, la vitesse, la variété, nécessitent-elles un recours à l’IA systématique, ou a contrario un traitement humain suffit-il et/ou est-il préférable ?

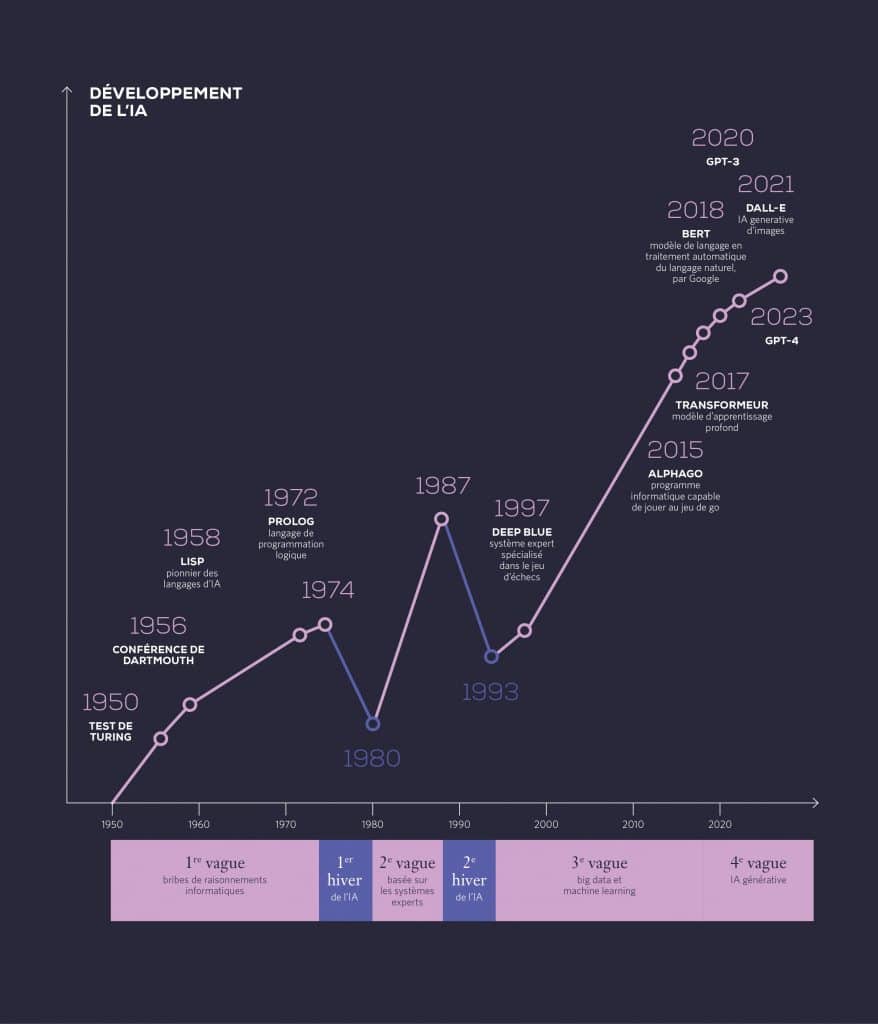

Petit historique du développement de l’IA

Notons que l’IA est apparue au début des années 1950 avec les premiers langages informatiques associés comme LISP (LIST processing, pour le traitement dit intelligent de listes) et le fameux test de Turing qui consiste à tester la capacité d’une machine à imiter une conversation humaine et à ainsi se faire passer pour un humain. Par ailleurs, après des surattentes quant aux usages possibles de l’IA, celle-ci a connu des vagues de reflux ou de déception, deux « hivers de l’IA » et des applications dans des champs plus étroits et spécialisés que ceux initialement envisagés ou fantasmés.

Plus récemment, les réseaux de neurones sont apparus, lesquels avec l’autoapprentissage et la possibilité d’établir des corrélations probabilistes entre éléments de données, alliés à la puissance de calcul des machines qui double encore tous les 18 mois selon la loi de Moore a permis une forte accélération de l’IA et de ses applications avec son corollaire, un caractère vraisemblable et épatant des réponses générées. Ainsi les grands modèles de langue (ou LLM, Large Language Model) sont des modèles entraînés sur un large corpus de textes permettant de mettre en œuvre ces IA.

Il est également légitime de se demander si nous ne connaîtrons pas à moyenne échéance un troisième hiver, comme la phase de décroissance du buzz et de l’engagement suscité par le métavers. Pour autant pour les IA génératives, l’horizon temporel s’est accéléré avec en France, par exemple, Sciences Po qui dès janvier 2023 demande aux étudiants de « mentionner de manière explicite » tout passage rédigé par ChatGPT, puis les mesures d’interdiction prises en Italie2. Par la suite, des fondateurs de ces systèmes ont demandé une pause de 6 mois dans leur développement en mars 2023 sous fond de peur de perte de contrôle de l’humain sur la machine. Enfin le Parlement européen, à défaut d’un terreau fertile pour permettre le développement de champions de l’IA en Europe face aux superpuissances du numérique que sont les États-Unis et la Chine, se prépare à réguler avec un AI Act pour disposer d’un cadre réglementaire d’ici fin 2023.

Il nous a semblé utile à ce stade de synthétiser les principales évolutions de ce qu’on appelle aujourd’hui « l’IA » dans le graphique ci-dessous jusqu’à la période actuelle où nous avons en outre les IA dites génératives qui s’ajoutent.

Algorithme et éthique

Comment des algorithmes pourraient-ils être entraînés à décider de ce qui est éthique ou non ? On pourrait prendre par exemple un projet de texte législatif, une bonne pratique à observer, une décision de recrutement sur un poste. Après une série de calculs et en cascade de sous-calculs – ce qui matérialise la décomposition d’un problème en sous-problèmes plus simples à résoudre – toujours par des choix binaires, une décision qualifiée d’éthique serait générée. Les questions sont nombreuses : qui écrit ces algorithmes ? Qui supervise leur écriture ? Sans forcément penser à mal, les choix seront évidemment différents selon l’auteur ou la formation initiale des programmeurs et des data scientists. Selon leurs conceptions, l’écriture d’algorithmes peut varier fortement sachant qu’il n’existe pas une façon unique d’écrire un programme3. La dimension culturelle de l’éthique est évidente ainsi que celle du choix de la langue. Et surtout, la dimension de la nuance, si importante en éthique, paraît mise à mal par ces approches binaires. Une professeure de l’Université de Bergen (Norvège), lors d’une conférence à SKEMA Business School, propose d’arriver à une moyenne éthique ; certes la nuance sera sans doute parfois oubliée, mais selon elle « c’est le prix à payer pour avoir des décisions qui fonctionnent »4 . Tout signal faible est ainsi balayé comme on le voit avec ChatGPT, très formaté, si politiquement correct que le contexte est écarté. En outre, ce politiquement correct conduit à des réponses qui ne sont pas exactes, mais justes d’un point de vue probabiliste avec un mélange des sources compilées sur le Web sans distinguer les sources pertinentes ou de référence de celles qui le sont moins et sans intégration de la dimension temporelle si précieuse dans l’analyse des données.

C’est la question du techno-solutionnisme qui est posée ici, à savoir, recourir à un outil technique comme première solution à tout problème. La question du besoin est d’emblée évacuée. Avons-nous besoin de ce mode de calcul pour définir l’éthique ? Le techno-solutionnisme revient à remplacer une solution non numérique par une solution numérique, parce qu’elle est numérique, et non parce qu’elle répond à un besoin. La consultation médicale par vidéo en est un exemple. Elle demeure utile lorsqu’il s’agit d’analyser des résultats, mais pas utile de façon universelle. La question des conséquences n’est ainsi pas envisagée.

Avec la profusion de contenu généré par les IA, il pourrait être intéressant de signaler le contenu produit exclusivement par les humains comme l’initiative de la Charte 100 % humain lancée lors de Vivatech 2023 le propose.

Aussi de premières recommandations seraient les suivantes :

Recommandation 1 : Face aux risques de confiance aveugle ou de manipulation potentielle de l’utilisateur, indiquer en filigrane qu’une réponse a été générée par une IA et qu’elle ne vaut pas vérité.

Recommandation 2 : Avoir une traçabilité des échanges et en complément de la portabilité des données, une portabilité des prompts et des réponses générées. Les questions du stockage de ces échanges et de la territorialité sont également à considérer pour des raisons de souveraineté et d’intelligence économique.

La liberté comme composante de l’éthique

Un sujet connexe est celui de la liberté qui fait aussi partie intégrante de la dimension éthique du numérique5. L’utilisation du numérique contribue-t-elle ou non à plus de liberté ? Et comment ? C’est une question qu’on devrait se poser constamment et qui devrait guider le progrès numérique et de la société. Par exemple, l’utilisation grandissante des moyens de paiements électroniques et dématérialisés, sous couvert de facilité pour le sans contact notamment, fait reculer l’utilisation d’espèces, de billets et de pièces : c’est une liberté en moins, celle d’acheter dans une brocante, de donner à des SDF même si en Chine il est possible de donner via des QR code, etc. Pire encore, c’est la garantie d’être toujours tracé, de voir se développer de nouveaux outils de traçages, avec des conséquences individuelles et collectives qu’on ne peut ignorer. Le tout numérique va directement à l’encontre de la conservation des espaces de liberté. On songe aussi aux conséquences individuelles du développement du métavers. On pense au sport et à ses formes en réalité virtuelle ou augmentée, que l’on nous propose de plus en plus. Ces questions préalables ne semblent pas être posées en amont du développement des techniques. La question des conséquences et d’une éventuelle régulation vient toujours après. L’éthique – au même titre que l’évolution du droit positif – court derrière le développement numérique alors que ce devrait être le contraire. C’est une question qui concerne les gouvernements, mais dont peu de gouvernants sont conscients parfois pour des questions de pouvoir.

Cette question de liberté est d’autant plus importante que nous avons vu lors de la pandémie de Covid-19, des citoyens privés d’accès à des restaurants ou dans différents lieux, car leur Pass Sanitaire ou Vaccinal n’était pas à jour. Quid demain si avec une convergence sur le smartphone nous avions Pass Sanitaire, Pass Environnemental et Pass de Paiement ? Si un citoyen a épuisé son crédit carbone par exemple, il ne lui serait plus possible de prendre l’avion ou le train même si son compte est suffisamment approvisionné en monnaie. Avec cette convergence et la fin de la monnaie fiduciaire, il ne disposerait pas d’un moyen auxiliaire pour régler. En arrière-plan se glisse indéniablement la question sensible de la cybersurveillance et de la régression des libertés6. Cela vient contre-balancer les missions de la CNIL et le RGPD qui sont contournées par les grandes plateformes et peut-être demain les États de façon plus insidieuse. La facilité de livrer nos données pour mieux les utiliser ne doit pas être source d’aliénation.

Une autre liberté est celle de la liberté d’expression laquelle doit être plurielle dans une démocratie dans le cadre du droit positif. Il n’est pas question de haine ou de propos injurieux à laisser se répandre en particulier sur les réseaux sociaux, laquelle est sanctionnée, mais de la difficile modération par l’IA. Celle-ci peut arbitrairement chasser des contenus qui manieraient par exemple l’humour et l’ironie ou qui ne rentreraient pas dans une doxa voire interdire des comptes en les déplateformisant. Deux autres recommandations suivent :

Recommandation 3 : L’utilisateur devrait être formé et informé plus finement quant au stockage de ses données personnelles, des aspects de respect de la législation.

Recommandation 4 : Dans le cadre d’une décision impactante comme le bannissement d’une personne sur un espace d’expression sur Internet, la décision de l’IA est à compléter par une supervision humaine pour trancher.

Enfin, cette liberté doit s’entendre en dehors même de l’expression consciente. Nous parlons là des « neurorights », c’est-à-dire du droit de chaque individu à ne pas être influencé de manière totalement subreptice par des formulations ou des procédés liés à l’IA. Ce sujet fera l’objet d’une étude spécifique de SKEMA PUBLIKA.

Débureaucratisation impérative

Un autre sujet pose des questionnements similaires : celui de la bureaucratie induite par les algorithmes. Nous passons beaucoup de temps à critiquer la bureaucratie et les règles qui nous enserrent, mais contre lesquelles nous pouvons éventuellement déposer un recours. Nous le voyions dans le passé, par exemple pour une contravention déposée à tort parce qu’une « pervenche » n’avait pas vu un ticket de stationnement, ou que celui-ci avait glissé dans l’habitacle de la voiture. Nous le voyions encore lorsqu’était en jeu le discernement d’un agent de police quant à un feu grillé qui pourrait être évalué selon la vitesse et le trafic, tantôt considéré comme rouge ou orange. Nous pouvions dans ces cas avoir des éléments de preuve et plaider notre bonne foi.

Qu’en est-il des algorithmes qui régissent nos vies de citoyens, nos allocations, notre énergie, voire notre alimentation ? De ce point de vue, au même titre que l’on peut s’inquiéter comme vu auparavant de la monnaie numérique comme seul outil financier, avoir un traitement administratif ne reposant que sur une IA, sans intervention humaine est un risque en cas de recours de l’administré qui, même s’il est dans son bon droit, risque fort de se voir opposé une fin de non-recevoir.

Aussi toute transformation digitale doit prévoir un mode manuel pour des exceptions et également des modes dégradés si le traitement par l’IA ne peut fonctionner. Par exemple l’utilisation d’espèces est un mode dégradé au paiement par carte lequel peut être pratique. On pourrait citer les cas de cyberattaques, de pannes informatiques ou d’opérations de maintenance même rares rendant la fonction impossible.

Enfin, suivant en cela les recommandations répétées des gouvernements pour simplifier la vie des citoyens, et écoutant les discours des prestataires de services numériques, un recours accru aux algorithmes et à l’IA devrait conduire à simplifier et sécuriser la vie des citoyens et pas l’inverse. On en est loin dans certains cas, quand la « dématérialisation » tant vantée conduit à des retards importants de délivrance de documents, notamment à l’étranger, ou à des bogues dans les processus électoraux, quand des actes quotidiens demandent la possession et la maîtrise de l’ordinateur ou encore quand la suppression de toute intervention humaine expose à des erreurs d’appréciation. L’utilisation de l’IA dans les administrations et les entreprises ne doit pas discriminer les personnes n’ayant pas les moyens ou le savoir pour y accéder. Les réels progrès dus à l’IA par exemple en médecine ne sauraient être une excuse à des dérives.

Recommandation 5 : Prévoir un accompagnement quant à l’utilisation de l’IA notamment pour les personnes les plus fragiles que ce soit pour accomplir les démarches ou en cas de recours.

Recommandation 6 : Toute transformation digitale doit prévoir des modes dégradés, en cas de coupure d’électricité, de zone non couverte par le réseau pour que les données puissent être collectées et traitées et que le service puisse être assuré même moins efficacement.

Recommandation 7 : La mise en place de procédures totalement automatisées reposant sur des algorithmes et sur l’IA ne devrait être décidée que lorsqu’un réel bénéfice, mesuré, en découle pour le citoyen et le consommateur (voir infra les recommandations du Conseil d’État sur la nécessité de « bénéfice »). Le bénéfice devant par ailleurs être pluriel : gain de temps, gain financier sans être dispendieux en matière environnementale.

IA, algorithme et développement durable

Les quantités de données consommées par les algorithmes peuvent aller à l’encontre des impératifs de sobriété énergétique et participer au réchauffement climatique ou à d’autres formes de pollution par rapport aux ressources disponibles. Est ainsi pointée la consommation d’eau dans les datacenters. Pour ChatGPT, 700 000 litres ont été nécessaires à la formation de GPT3 d’OpenAI et 0,5 litre est nécessaire par requête effectuée par internaute lors de l’utilisation. Et au fil des générations GPT, le nombre de paramètres suit une progression exponentielle inquiétante. La seule question qui prévaut lorsque l’on parle de service à la population est la suivante : « En quoi la solution technologique va-t-elle accroitre la satisfaction tout en rejoignant des exigences d’intérêt général comme la sobriété numérique ? ».

Il est également possible de concevoir en amont des algorithmes plus performants comme la complexité d’un algorithme de tri en O (n log n) au lieu de O (n * n). Il est souhaitable d’imaginer des solutions disruptives. Ainsi la solution Hive utilise le stockage des PC et des smartphones des internautes pour proposer une solution de cloud souverain qui maximise l’utilisation des ressources plutôt que de recourir à des datacenters et des baies de stockage sachant que près de 50 % de la consommation énergétique d’un datacenter est liée à sa gestion (refroidissement, etc.).

Recommandation 8 : Rechercher des solutions pour la frugalité des algorithmes afin qu’ils soient plus performants et moins énergivores avec par exemple moins de données utilisées pour un même résultat ou alors une performance moindre avec un facteur d’utilisation de ressources n fois inférieur.

Établir des principes applicables à l’IA

Un rapport du Conseil d’État français de mars 2022 délivre quelques pistes. En France, l’administration doit être en capacité de démontrer que son choix de recourir à un système d’IA et les modalités de fonctionnement qu’elle a définies sont guidés par la préoccupation d’apporter un bénéfice à la collectivité humaine. En corollaire, elle doit garantir son accessibilité à tous.

Ainsi, l’exigence de bénéfice humain suppose de s’extraire de l’immédiateté pour analyser les conséquences à long terme du système. Et cela doit être fait dès la préparation de la loi.

Le rapport du Conseil d’État mentionne aussi le principe de finalité. Par exemple, les données à caractère personnel doivent être traitées de manière compatible avec les finalités pour lesquelles elles ont été collectées.

Au plan international, l’OMS a publié son premier rapport mondial sur l’IA en santé et dont les grands principes peuvent être transposés à d’autres secteurs. Elle identifie six principes directeurs relatifs à sa conception et à son utilisation : protéger l’autonomie de l’être humain ; promouvoir le bien-être et la sécurité des personnes ainsi que l’intérêt public ; garantir la transparence, la clarté et l’intelligibilité ; encourager la responsabilité et l’obligation de rendre des comptes ; garantir l’inclusion et l’équité ; promouvoir une IA réactive et durable.

Enfin, la question de la donnée est au cœur de ces problématiques. Car les données sont les nouvelles matières premières, qui comme les traditionnelles donnent lieu à une énorme compétition, parfois déloyale, ainsi qu’à des prédations, comme c’est le cas pour les ressources naturelles. Les données doivent toujours pouvoir être gérées par des lois protectrices : protectrices d’essais non éthiques, comme les données médicales, protectrices du traçage de la vie, non seulement du point de vue de leur protection privée, mais aussi de la finalité de leur utilisation. Les États riches en données médicales, comme la France, sont de ce point de vue des cibles de choix. L’IA renforce l’acuité d’une réponse à ces enjeux qui en réalité relèvent de décisions politiques.

Concrètement, la réflexion éthique généraliste doit inspirer la réflexion éthique opérationnelle, en la faisant respecter dès la conception technique et le déploiement de la digitalisation par des équipes dûment informées. Cette conception « ethic by design » ne doit pas être aléatoire et laissée au seul jugement de ceux qui écrivent les algorithmes, mais répondre à des standards cependant suffisamment larges pour ne pas devenir de nouveaux impératifs rigides. Pour paraphraser une maxime qui concernait initialement l’armée : la numérisation est une chose trop importante pour être laissée aux seuls numériciens.

Comment établir ces principes ?

Aujourd’hui une multitude d’acteurs et autant d’initiatives se préoccupent du sujet de l’éthique et de l’IA, comme l’indique et le détaille un article de juin 2023 de M. Gornett et W. Maxwell, qui nous rappelle au passage que le dictionnaire Larousse définit l’adjectif éthique comme « qui concerne la morale » tandis que le Robert ajoute « qui intègre des critères moraux dans son fonctionnement ».

Les auteurs nous rappellent aussi que la coexistence de normes européennes et internationales cache des enjeux géopolitiques et qu’en dehors de ces initiatives de niveau supranational, de multiples autres se développent dans des instances professionnelles, dans des organismes de standardisation privés voire dans des entreprises.

Faut-il les laisser se développer ou rechercher un cadre global de responsabilité ? Avec les risques liés à une gouvernance mondiale unique ?

Aujourd’hui, à l’échelon multilatéral mondial, l’UNESCO a pris une avance certaine en ayant dès novembre 2021 émis une « recommandation sur l’éthique de l’intelligence artificielle », qui a été adoptée par les 193 États membres de l’UNESCO. Il s’agit selon l’organisation onusienne du « tout premier instrument normatif mondial sur le sujet, qui permettra non seulement de protéger, mais aussi de promouvoir les droits humains et la dignité humaine, et constituera une boussole éthique et un socle normatif mondial permettant d’instaurer un solide respect de l’État de droit dans le monde numérique ». En juin 2023, ces principes ont fait l’objet d’un atelier à l’occasion de la Conférence AfricAI à Kigali, au Rwanda, pour examiner son Référentiel de compétences sur la transformation numérique en Afrique et en Inde.

Au niveau normatif international ensuite, l’ISO dispose d’un sous-comité SC 42, Intelligence artificielle qui a pour objectif de créer une société d’IA éthique. On est là dans un champ qui suppose l’affrontement quasi politique d’objectifs d’influence et une fois la norme établie, des systèmes de certification qui seront à coup sûr des opportunités d’affaires très importantes pour les organismes prestataires.

On ne peut pas ne pas citer la réflexion française, très avancée, notamment l’avis rendu le 30 juin 2023 par le Comité national pilote d’éthique du numérique (CNPEN) qui développe plusieurs préconisations pour encadrer le développement des logiciels d’Intelligence artificielle générative, comme ChatGPT. Ce texte vise les risques de manipulation ou de désinformation. Il propose aussi un principe que nous citions ci-dessus, même si le nom en est différent, qui consiste à s’assurer d’une éthique commune dans la conception même des algorithmes, et propose pour ce faire un règlement européen, dont la base existe déjà.

Il est urgent pour les gouvernements démocratiques de s’emparer de ces questions en lien avec les représentants des citoyens, les assemblées parlementaires. La gestion de la digitalisation de la société a déjà beaucoup avancé sans trop leur demander leur avis. Saisissons le développement de l’IA comme une opportunité pour améliorer le contrat social qui lie le citoyen à l’État. L’État démocratique a des pouvoirs légitimes tant qu’il remplit les besoins des citoyens, spécifiquement celui de leur protection.

- Lancé le 30 novembre 2022. En l’espace de 5 jours, un million de comptes ont été créés, ce qui constitue le laps de temps le plus court pour atteindre ce cap par une technologie. ↩︎

- Le 31 mars 2023, l’organisme de surveillance de la protection des données en Italie, la Garante per la protezione dei dati personali, a décidé d’interdire temporairement et immédiatement l’accès à ChatGPT et OpenAI à cause de soupçons de violations de la vie privée. ↩︎

- The Art of Computer Programming, Donald E. Knuth, Addison-Wesley, 1968-2022. ↩︎

- « The world is ‘colourful’, whereas computers only read ‘black and white’ [..]. To use an algorithm, the rules and the moral information need to be specified in a formal language. Formal here just means unambiguous. […] I do think ambiguity is useful but we do not have the luxury of it when making computer programs. » ↩︎

- Un des thèmes de la conférence The ethics and respect within the Metaverse, le 24 novembre 2022, organisée par les ONG Institution Citoyenne et Respect Zone. ↩︎

- Adieu la liberté. Essai sur la société disciplinaire. Mathieu Slama, Presse de la Cité, 2022. ↩︎